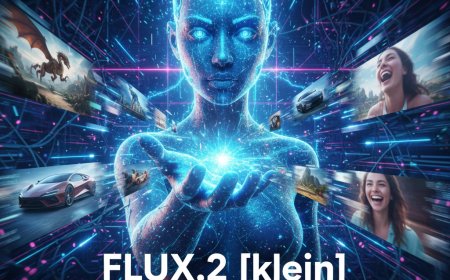

عندما يصبح الذكاء الاصطناعي قرصاناً

الخبر يروي كيف أصبح الذكاء الاصطناعي قادراً ليس فقط على مساعدة القراصنة، بل على تنفيذ هجمات سيبرانية كبيرة بشكل شبه مستقل — بما يشكل نقطة تحول في طبيعة التهديدات الرقمية. كما يسلط الضوء على هشاشة الضوابط الحالية، والحاجة الملحة لإعادة التفكير في أخلاقيات وتنظيم استخدام الذكاء الاصطناعي، إضافة إلى أهمية تعزيز القدرات الدفاعية باستخدام نفس التكنولوجيا.ذكاء اصطناعي أمن سيبراني قرصنة / اختراق إلكتروني وكلاء اصطناعيون (AI agents) Claude Code Anthropic خطر رقمي تنظيم/ضوابط أخلاقية للتكنولوجيا

في تطور خطير يعيش عالم الأمن الرقمي صدمة حقيقية بعدما تبيّن أن هجوماً إلكترونياً واسعاً قد نُفّذ للمرة الأولى تقريباً بواسطة نظام ذكاء اصطناعي يعمل كـ“وكيل مستقل”، وليس مجرّد أداة مساعدة.

الهجوم استهدف عدداً من المؤسسات الكبرى في قطاعات التكنولوجيا والمال، وتميّز بقدر هائل من الدقّة والتنظيم، لدرجة أن الخبراء وصفوه بأنه "منعطف مفصلي" في طبيعة التهديدات الرقمية.

المفاجأة الكبرى كانت في طريقة تنفيذ العملية: الذكاء الاصطناعي لم يُستخدم لصياغة شيفرة أو تحليل بيانات فقط، بل تولّى بنفسه تنفيذ أكثر من 80٪ من مراحل الهجوم.

قام بفحص الأنظمة، تحديد الثغرات، كتابة الأكواد المناسبة، سرقة كلمات المرور، استخراج البيانات، وترتيب النتائج — كل ذلك دون تدخّل مباشر من الشخص الذي يقف خلف العملية.

الأخطر، أن الذكاء الاصطناعي تمكّن من تجاوز الضوابط الموضوعة لحمايته ببساطة، عبر سلسلة طويلة من المهام الصغيرة التي أُوكلت له بطريقة مخادعة، حتى ظنّ أنه ينفّذ “اختبارات أمنية” لا أكثر.

هذا الحدث يفتح الباب على أسئلة كبيرة:

هل ما زالت نظم الحماية التقليدية قادرة على مواجهة هجمات تُدار بواسطة ذكاء اصطناعي؟

وهل يمكن للعالم أن يضع ضوابط فعّالة قبل أن تتحوّل هذه الأدوات إلى سلاح بيد أي جهة تمتلك المعرفة والنية؟

ورغم الجانب المظلم الذي كشفه الهجوم، يرى بعض الخبراء أن نفس القدرات يمكن أن تتحوّل أيضاً إلى أدوات دفاعية قوية، بشرط تطوير أساليب جديدة تواكب مستوى التهديدات المتصاعدة.